Maschinelles Lernen in der Teilchenphysik

Die Hochenergiephysik (HEP) zeichnet sich durch große Mengen hochdimensionaler Daten aus, die beispielsweise mit den Experimenten am Large Hadron Collider (LHC) am CERN in der Schweiz gesammelt oder gemäß theoretischer Vorhersagen auf der Grundlage der Quantenfeldtheorie simuliert werden.

Diese Simulationen folgen einer Kette von mehreren Schritten, beginnend mit dem Hochenergieprozess von Interesse, gefolgt vom Zerfall schwerer, instabiler Teilchen (manchmal über einen sogenannten Partonschauer) und der Hadronisierung farbgeladener Teilchen in farblose beobachtbare Teilchen. Anschließend wird die Wechselwirkung aller erzeugten Teilchen mit dem Detektormaterial simuliert, was zu einem Datenformat führt, das mit den in Experimenten aufgezeichneten Signaturen identisch ist.

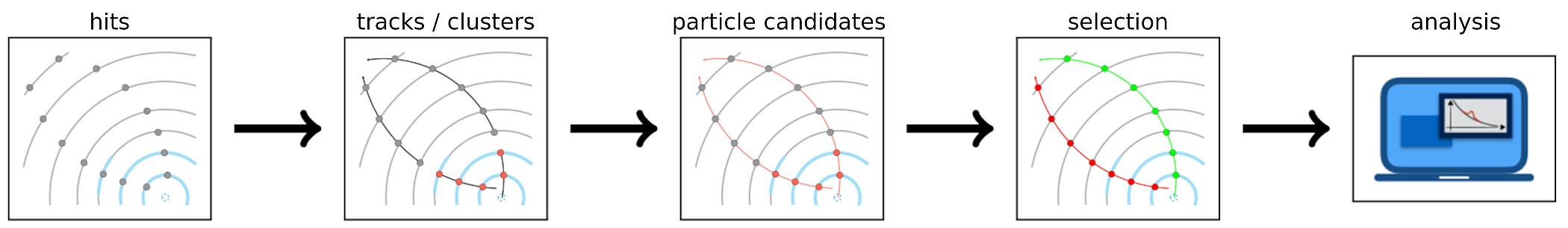

Für die Analyse werden die Detektorsignaturen, sogenannte Hits, zunächst entweder in Cluster (im Kalorimetersystem) oder in Tracks (im Trackersystem) gruppiert. Diese werden dann zu Teilchenkandidaten zusammengeführt, die zur Auswahl interessanter Ereignisse für Analysen verwendet werden.

Simulationskette. Bild von SciPost Phys. 14 (2023) 4, 079 und Ramon Winterhalder.

Von Detektorsignaturen zur Analyse. Bild basiert auf Comput.Softw.Big Sci. 7 (2023) 1, 1, editiert von Claudius Krause.

Modernes maschinelles Lernen (ML) hat in den letzten Jahren viele neue Ideen und Verbesserungen in die Hochenergiephysik (HEP) eingebracht. Auf der experimentellen Seite umfasst dies die Datenerfassung, Teilchenrekonstruktion und -auswahl sowie die anschließende Analyse. Auf der theoretischen Seite hat ML erheblich zu besseren und schnelleren Simulationen und Parameterabschätzungen beigetragen. Insgesamt hat ML nicht nur zu signifikanten Verbesserungen bestehender Algorithmen geführt, sondern auch zu neuen Ideen für zuvor als unlösbar betrachtete Probleme.

ML hat ein breites Anwendungsspektrum in der HEP. Fast alle verschiedenen Zielsetzungen (wie Regression, Klassifikation, Generierung) auf verschiedenen Datentypen (wie tabellarischen Daten, Point Clouds, Graphen) werden erforscht, wie auch in der HEP-ML Living Review zu sehen ist.

Die HEP ML Gruppe am HEPHY

Am HEPHY untersuchen wir, wie ML einzelne Schritte der oben genannten Simulationskette sowohl in „vorwärts“- als auch in „rückwärts“-Richtung verbessern kann. Bisher haben wir uns auf zwei Hauptbereiche konzentriert: schnellere Simulationen mit generativen Modellen (Deep Generative Models) und Anomalieerkennung (Anomaly Detection) bei der Suche nach neuer Physik.

Generative Modelle in Teilchensimulationen

Generative Modelle haben in den letzten Jahren durch große Sprachmodelle und Bildgeneratoren viel Aufmerksamkeit erlangt. In der HEP können sie als Ersatzmodelle verwendet werden, um sonst langsame Simulationscodes zu beschleunigen. Die Hauptanwendung dieser Idee ist die Simulation von Teilchenwechselwirkungen in den Kalorimetersegmenten der Detektoren. Eine sehr detaillierte Simulation unter Verwendung der GEANT4-Bibliothek ist langsam, da sie alle Teilchen und deren Sekundärteilchen durch das gesamte Detektorvolumen verfolgt. Ein generatives Modell hingegen lernt, die im Detektor deponierten Energien zu sampeln und mehrere Shower parallel zu erzeugen, wodurch die Generierung um bis zu vier Größenordnungen beschleunigt wird.

Im Gegensatz zur Generierung von natürlichen Bildern (Fotos oder Kunst), bei denen wir hochrealistische einzelne Beispiele bevorzugen, sind wir mehr daran interessiert, die gesamte Verteilung der Duschen über den Phasenraum (d. h. in allen Energiebereichen) korrekt wiederzugeben. Diese unterschiedlichen Anforderungen erfordern daher andere Architekturen im Vergleich zu Bildgeneratoren und auch spezialisierte Evaluierungsmetriken, die auf die HEP zugeschnitten sind. Die HEP ML-Gruppe am HEPHY koordiniert und bewertet derzeit die Fast Calorimeter Simulation Challenge, die darauf abzielt, die am besten geeignete generative Architektur für die schnelle, originalgetreue und leichte Kalorimeter-Duschgenerierung zu finden. Diese Ergebnisse werden die Architektur liefern, auf der die nächste Generation der schnellen Detektorsimulation basiert. Kürzlich haben wir auch einen Review Artikel über generative Modelle für die Detektorsimulation veröffentlicht.

Eine weitere Anwendung generativer Modelle, insbesondere von Architekturen auf Basis von Normalizing Flows, in der HEP ist die verbesserte Effizienz beim Importance Sampling. Importance Sampling ist ein numerisches Werkzeug, das Monte-Carlo-Schätzungen für komplizierte Integrale verbessert und es ist der Kern aller Ereignisgeneratoren wie Sherpa oder MadGraph.

Anomalieerkennung in experimentellen Daten

Physik jenseits des Standardmodells könnte sich in den aktuellen experimentellen Daten verbergen, und unsere gezielten Suchmethoden könnten blind dafür sein, wenn wir uns auf die falschen Signaturen konzentrieren. Mit der Anomalieerkennung verbessern wir dies, indem wir versuchen, die Nadel im Heuhaufen zu identifizieren, ohne tatsächlich zu wissen, wie eine Nadel aussieht. Im Kern vieler ML-Methoden zur Anomalieerkennung liegt die Beobachtung, dass ein Klassifikator, der darauf trainiert ist, zwei gemischte Sets unterschiedlicher Signal-/Hintergrundzusammensetzung zu unterscheiden, automatisch auch optimal ist, um Signal von Hintergrund zu unterscheiden. Dies ist bekannt als "Classification WithOut LAbels (CWoLa)". Konditionierte generative Modelle können jetzt verwendet werden, um auf datengetriebene Weise ein signalarmes Datenset zu konstruieren, das zum Training eines CWoLa-Anomalieerkennungsmodells verwendet werden kann. Wir haben diese Methode „Classifying Anomalies THrough Outer Density Estimation (CATHODE)“ genannt und kürzlich hat die CMS-Kollaboration sie bei der Suche nach neuer Physik verwendet.

Mitarbeiterinnen und Mitarbeiter

Machine Learning

Claudius Krause

Gruppenleiter Machine Learning+43 (1) 51581 - 2880